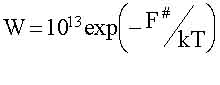

Начиная с работ по классической теории информации, установилась традиция связывать информацию с термодинамической величиной - энтропией. Начало этой традиции было положено Н. Винером, увидевшем действительно бросающееся в глаза сходство формул Шеннона для количества информации I и формулы Больцмана для энтропии S. Различие в размерности устранялось выбором единиц измерения I, которое можно измерять и в энтропийных единицах. В дальнейшем появилось слово "негоэнтропия" и утверждение: "информация есть негоэнтропия" Эти слова многократно повторялись в научных статьях, книгах и даже в учебниках. У людей, занимающихся конкретными проблемами информатики эти слова вызывали (и продолжают вызывать) недоумение и раздражение (внутренний дискомфорт), потому, что "что-то здесь не так". В этом разделе мы обсудим что именно "не так" и почему. Согласно определению (Q) информация есть запомненный выбор (т.е. макроинформация). На физическом языке "запомнить", то есть зафиксировать информацию, означает привести систему в определенное устойчивое состояние. Ясно, что таких состояний должно быть не меньше двух. Каждое из них должно быть достаточно устойчивым, в противном случае система может самопроизвольно выйти из того или иного состояния, что равносильно исчезновению информации. Простейшая запоминающая система содержит всего два устойчивых состояния и называется триггер (переключатель). Этот элемент играет важную роль во всех информационных системах. В электронике в качестве запоминающего триггера используют магнитные домены (размеры порядка микрон), а также электрические и светочувствительные ячейки (тоже микронных размеров). Свойством запоминания могут обладать только макроскопические системы, состоящие из многих атомов. Запомнить что-либо, располагая одним атомом, невозможно, поскольку атом может находиться лишь в одном устойчивом (основном) состоянии. То же относится и к простейшим молекулам. Наименьшая по своим размерам самая простая система, которая может запомнить один вариант из двух возможных, это молекула, способная находиться в двух различных изомерных состояниях при условии, что спонтанный переход из одной формы в другую может происходить так редко, что его вероятностью практически можно пренебречь. Примером таких молекул могут служить оптические изомеры, обладающие "левой" или "правой" киральностью, различающейся по способности содержащих их растворов вращать вправо или влево плоскость поляризации света, пропускаемого через растворы. К таким оптическим изомерам относятся сахара и аминокислоты, содержащие десять-двадцать атомов. Молекулярными триггерами могут служить макромолекулы (в частности, белковые молекулы), способные существовать в нескольких (по крайней мере двух) конформационных состояниях. Системы более высокого иерархического уровня, такие как клетка, популяция, организм, мозг, разумеется, тоже могут быть запоминающими. Механизм запоминания при этом не всегда сводится к генетическому (то есть макромолекулярному). Например, клетка (в частности, нервная), способная функционировать в двух и более устойчивых состояниях, уже является запоминающим устройством. Тоже можно сказать о популяции и организме. Механизм запоминания в нервных сетях (в частности, в мозге) имеет свои особенности, которые мы обсудим позже. Важную роль играет время запоминания. В устойчивых динамических системах оно формально бесконечно. Переключить триггер из одного состояния в другое можно лишь за счет стороннего сигнала, что равносильно рецепции (см. выше). В реальности возможно спонтанное переключение (т.е. забывание исходного состояния) за счет случайных флюктуаций. Вероятность спонтанного переключения в единицу времени зависит от величины флюктуаций и высоты барьера F# между состояниями. В термодинамически равновесных (по микроскопическим степеням свободы) условиях эта вероятность равна:

|

|

|

|

|

|

Здесь: 1013 сек-1 - частота тепловых флюктуаций. Время запоминания Т= 1/W. При F# порядка 1,5 эВ время Т = 3·105 лет, что практически можно считать бесконечным. Мы остановились на этом столь подробно, чтобы продемонстрировать: Во-первых, макроинформация может содержаться только в макрообъектах. Во-вторых, граница между макро и микро объектами проходит на уровне макомолекул, размеры которых порядка нанометров (10-9 метра или 10-7 сантиметра). Современная наноэлектроника подбирается к этой границе. Наряду с макроинформацией выше упоминалось о микроинформации, которой соответствует выбор принципиально не запоминаемой. Примером последнего может служить выбор одного микросостояния идеального газа в состоянии термодинамического равновесия. Выбор микросостояния означает, что нам удалось в определенный момент времени t изменить координаты и скорости всех молекул с определенной точностью. Разумеется, это возможно лишь умозрительно, но и в этом случае выбранное состояние тут же (за время t ~10-13 сек), будет забыто, то есть сменится другим микросостоянием, выбранным по закону случая. Это свойство - забывать предыдущее микросостояние - является фундаментальным для эргодических систем. в которых средние по времени совпадают со средними по ансамблю. Именно оно понимается под словами "молекулярный хаос" и именно оно лежит в основе термодинамики. Количество микроинформации в данном примере велико, согласно (1.3) оно равно:

Imicro=log2n=-log2W, (1.5)

где, nmicro число микросостояний, W=1/nmicro - вероятность случайно выбрать какое-либо одно из них. Количество макроинформации в том же примере, напротив мало; именно Imаcro= log2 nmаcro = 0, поскольку макросостояние равновесного газа единственно, то есть nmаcro = 1. Разумеется, макроинформация не может быть ни ценной ни смысловой и вообще не может использоваться, как информация в реальной жизни. Тем не менее она широко обсуждается и является источником многих недоразумений. Причину тому следующая: Во-первых, формула (1.5) следующая из формулы Шеннона, очень похожа на формулу Больцмана для энтропии.

(1, 6)

(1, 6)

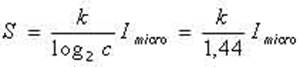

Здесь k =1,38 10-23 Дж/град. - постоянная Больцмана. Поэтому микроинформация и энтропия пропорциональны друг другу:

(1.7)

(1.7)

В действительности формула (1.7) представляет собой связь между энтропией и микроинформационной емкостью (или "тарой"), поскольку сравниваются энтропия до измерения (S(t)) и количество микроинформации после измерения I(t+τ). Можно, (только умозрительно) оценить энтропию сразу после измерения, то есть до того как наблюденное состояние разрушится (т.е. в течение t ~ 10-13 сек). С точки зрения термодинамики нахождение макросистемы в одном микросостоянии - колоссальная флюктуация. Энтропия ее много меньше равновесной энтропии S (до измерения). Именно:

|

|

|

S(t+τ)=k ln W(t|t+τ) (1.8)

где W(t|t+τ) - условная вероятность того, что в момент t+τ будет наблюдено то же макросостояние, которое реализовалась в момент t. Ясно, что W(t|t+τ) =1 и S(t+τ) =0. Отсюда следует, что в результате измерения энергия уменьшалась на величину

ΔS=S(t+τ)-S(t)=- S(t).

Количество информации до измерения, когда выбор еще не сделан Imicro(t) =0, поэтому прирост количества макроинформации ΔImicro= + Imicro . Отсюда делается вывод:

(1.9)

(1.9)

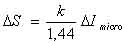

Интерпретация выражения (1.9) такова: при увеличении информации о системе ее энтропия уменьшается. Отсюда же происходит крылатое выражение "информация есть негоэнтропия". Во-вторых микроинформацию и энтропию связывает еще "демон" Максвелла. Демон впервые появился более ста лет тому назад (в 1871 г.) в книге К. Максвелла "Теория теплоты", как парадокс, демонстрирующий возможность нарушения второго начала термодинамики. Напомним суть дела. Имеются два сосуда с газом при исходно одинаковой абсолютной температуре Т. Они разделены перегородкой, в которой имеется отверстие с заслонкой. Заслонкой управляет "демон", он фиксирует скорости и в одну сторону пропускает только быстрые молекулы, а в другую - только медленные. В результате через некоторое время в одном сосуде температура повышается, а в другом - понижается. Таким образом, тепло переходит от холодного тела к более теплому без совершения работы (на первый взгляд) - второе начало нарушается и энтропия уменьшается. Разрешение парадокса было предложено известным физиком, много сделавшем для развития теории конденсированных сред, Леоном Бриллюеном. Он показал, что даже демон бесплатно ничего не делает (так уж устроен наш мир). Для фиксации скорости молекулы, т.е. получению информации, демону нужно заплатить энергией, не меньшей, чем энергия теплового кванта kT (при комнатной температуре Т =300оК, kT = 0,025 эВ). Энергия kT /1,44 - минимальная цена одного бита микроинформации (1,44 - коэффициент перехода от натуральных логарифмов к двоичным). После этого стало ясно, что демон совершает работу и как раз такую, которая необходима для охлаждения одного тела и нагревания другого. По существу любой домашний холодильник работает как демон и за это тоже нужно платить. При этом демон получает информацию равную уменьшению энтропии. Так возникло утверждение: "информация есть негоэнтропия". Приставку "микро" при этом по недосмотру опустили, а зря, поскольку именно это привело к серьезным недоразумениям. Разрешение парадокса всегда вдохновляет. Поэтому среди физиков - последователей Бриллюена - демон и слово "негоэнтропия", как синоним информации, стали часто употребляться - возник миф о негоэнтропии. Справедливости ради, следует заметить, что Бриллюэн различал свободную информацию (не давая ей, к сожалению, четкого определения) и связанную информацию, возникающую, когда возможные случаи "могут быть представлены как микросостояния физической системы". И далее: "Только связанная информация будет представляться связанной с энтропией". Отсюда ясно, что, во-первых, на деле Бриллюэн не приписывал любой информации свойства негэнтропии, а во-вторых, ограничивал свое рассмотрение только той частью информации, которая связана с микросостояниями. Так что к недоразумению привели не сам Бриллюен, а его эпигоны. После этих разъяснений формализм Бриллюэна выглядит очень просто и результаты расчетов соответствуют (1.9). Реально ни физического, ни информационного содержания термин "негэнтропия" не имеет (он от "демона"). Что же касается той информации, которой занимался Бриллюэн, то сам он называл ее "связанной"; в отечественной литературе принят термин "микроинформация". Микроинформация существенно отличается от макроинформации, поскольку она не имеет важного для информации свойства фиксируемости, ибо незапоминаема. Макроинформация существенно отличается от микроинформации не только качественно, но и количественно. Это ясно, если вернуться от энтропийных к обычным единицам измерения информации - битам.

|

|

|

Iмикро = - (ΔS/k)log2e = - 1,44 ΔS/k (1.12)

Iмикро - огромное число, ибо k = 1,38 10-23 Дж/К (ΔS < 0),

Iмaкро << - (ΔS/k)log2e.

Причина этого неравенства в том, что запоминание - процесс макроскопический и диссипативный, он сопровождается большим изменением энтропии. Количественное различие ясно из следующих соображений. Формула (1.3) справедлива как для микро-, так и для макроинформации, но существенно различны числа возможных вариантов n. В случае макроинформации n - число устойчивых состояний системы, оно, как правило, невелико. В случае микроинформации n - полное число микросостояний, (неустойчивых, то есть микроскопических) - оно огромно.

Яркий пример тому приведен в книге Блюменфельда "проблемы Биофизики" [25]. Показано, что вся информация, заключенная в человеке (включая ДНК, белки, а также мысли, как тайные, так и явные), будучи выраженной в энтропийных единицах, соответствует энтропии испарения одного пол-литра кипяченой воды (на самом деле, не так уж важно, чего именно).

Всякий раз, когда в акте творчества создается новая ценная информация, мы имеем дело с макроинформацией. Из книг, лекций, природы мы рецептируем макроинформацию. Вообще в реальной жизни, в частности, в биологии всегда используется макроинформация, которую мы в предыдущих и в последующих разделах называем просто информацией.

Любое изменение макроинформации, увеличение или уменьшение, сопровождается ростом энтропии, что естественно, поскольку эти процессы необратимы. Количественной связи между изменениями макроинформации и физической энтропии не существует. Энергетическая цена макроинформации, конечно, существует, она определяется энергией, диссипирующей в процессе запоминания и зависит от конкретных условий, в частности от времени на которое информацию нужно запомнить, то есть от свойств ячейки памяти. Эта энергия, приходящаяся на один бит информации, заведомо (и много) больше kТ /1,44 - энергии одного бита микроинформации.

Таким образом, слово негоэнтропия - появилось в результате не пониманя роли условия запоминания информации. Слово негоэнтропия - пример условной информации, которая в действительности не ускорила, а, напротив, затруднило исследование информационных процессов, то есть оказалась на деле дезинформацией. Именно от этого предостерегал Шеннон, слова которого мы уже приводили выше.

В заключение раздела обсудим ещё одно недоразумение, связанное с понятием "порядок". Часто можно встретить утверждение о том. что информация - мера упорядоченности, оно фигурирует даже в коллекция определений.

Это утверждение воспринимается как объективное (безусловное). На самом деле требуется уточнить. какая именно информация (ценная или нет, условная или безусловная) имеется в виду. Надо уточнить также, что понимается под словом "порядок". Без этих уточнений утверждение теряет смысл. В действительности в приведенном утверждении неявно предполагается, что информация ценная, но в этом случае она наверняка условная, ибо зависит от цели.

Понятие "порядок" тоже целесообразно. Так, если цель - прогноз, то упорядоченными следует считать системы, развивающиеся устойчиво и допускающие предсказание результатов. Именно в этом смысле в физике хаотические системы считаются беспорядочными и энтропия здесь выступает как мера беспорядка. В более общем случае, когда преследуются иные цели, меняется и смысл слова "порядок". Для иллюстрации приведем пример из жизни.

Пусть некто (писатель или ученый) пишет книгу. Для этой цели он расположил материалы в определенном порядке: рукопись - на столе, черновики - под столом, статьи и книги - на стуле и диване. В кабинет входит жена и приходит в ужас, поскольку у неё другие цели и другое представление о порядке. Представьте, что ученый отлучился на время, а когда вернулся, жена встретила его радостными словами: "я, наконец-то навела порядок в твоем кабинете". Представить состояние ученого в этот момент уже не трудно. Из этого примера следует, что порядок - понятие условное в той же мере, как и ценная информация.

Утверждение: "Ценная информация есть мера условного порядка" имеет четкий смысл, оно правильно и. более того, банально. Отсюда ясно, что искать объективную меру объективного порядка бессмысленно, ни того, ни другого просто не существует. В действительности проблема порядка и хаоса имеет много аспектов и к ней мы ещё вернемся в разделе 3 (у Д.С. Чернавского в гл 7).

В заключение главы отметим, что: все (или почти все) определения, приведенные в "коллекция" имеют смысл и относятся к разным сторонам информационного процесса. Объединить эти определения, увидеть общую картину информационного процесса и понять суть феномена информации позволяет теория динамических систем, или, что то же, синергетика. Это не случайно, развивающиеся сложные системы имеют много аспектов. В гуманитарных науках это свойство предстоит как многоликий образ - термин яркий эмоциональный, метафорический, но не четкий. В синергетике то же предстоит вполне конкретно, как мультистационарность [27] или, что то же, многовариантность [34], многомодальность [35]. В синергетике эти понятия формулируются четко и конструктивно, так, что с ними можно работать.

2014-02-24

2014-02-24 1390

1390