Рассмотрим вопросы реализации байесовского подхода к задачам классификации в медицине.

В общем плане задача байесовской статистики состоит в возможности оценки плотности вероятности распределения параметров модели по имеющимся примерам. При решении задачи классификации можно оценить плотность вероятности принадлежности к каждому классу, сравнить их между собой и выбрать наиболее вероятный. Более традиционный подход к решению этой задачи состоит в том, чтобы построить оценку для плотности вероятности по имеющимся данным. При этом обычно предполагается, что плотность вероятности имеет некоторый определенный вид (чаще всего предполагается нормальный закон распределения плотности вероятности). После этого задача сводится к оценке параметров распределения по имеющимся данным, причем предположение о нормальности не всегда может быть достаточно четко обосновано и используется лишь потому, что в этом случае параметры модели можно оценить аналитически.

Другой подход к оценке плотности вероятности основан на методе ядерных оценок (Parzen 1962; Spekt 1990; Spekt 1991; Bishop 1995, Patterson 1996). Схематически ход рассуждения может быть представлен следующим образом: тот факт, что данный пример (из обучающего множества примеров, по которым строится модель) расположен в данной точке N -мерного пространства входных признаков  ={ x1, x2, … xN }, свидетельствует о том, что в этой точке пространства функция плотности вероятности принадлежности наблюдения к данному классу Y отлична от 0. Кластеры из близко лежащих точек указывают на то, что в этом месте плотность вероятности больше. При этом вблизи примера имеется большое доверие к уровню плотности вероятности, а по мере отдаления от него доверие убывает и стремится к нулю. В методе ядерных оценок в точке, соответствующей каждому наблюдению, помещается некоторая простая функция, затем все они складываются и в результате получается оценка для общей плотности вероятности. Чаще всего в качестве ядерных функций берутся гауссовы функции:

={ x1, x2, … xN }, свидетельствует о том, что в этой точке пространства функция плотности вероятности принадлежности наблюдения к данному классу Y отлична от 0. Кластеры из близко лежащих точек указывают на то, что в этом месте плотность вероятности больше. При этом вблизи примера имеется большое доверие к уровню плотности вероятности, а по мере отдаления от него доверие убывает и стремится к нулю. В методе ядерных оценок в точке, соответствующей каждому наблюдению, помещается некоторая простая функция, затем все они складываются и в результате получается оценка для общей плотности вероятности. Чаще всего в качестве ядерных функций берутся гауссовы функции:

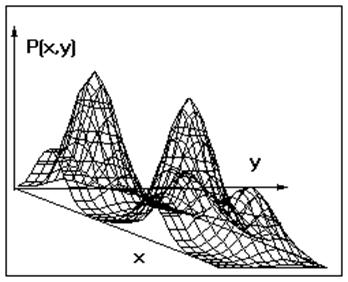

где A – нормирующий множитель, - среднее значение i -ой координаты для данного примера из обучающего множества, коэффициент a управляет степенью сглаживания гауссовых функций (параметр, который подбирается при обучении нейронной сети). Если обучающих примеров достаточное количество, то такой метод даст достаточно хорошее приближение к истинной плотности вероятности. На рисунке 3 приведен в качестве примера вид такой функции в двумерном случае (здесь рассмотрено 6 примеров, находящиеся в 4-х различных точках пространства).

- среднее значение i -ой координаты для данного примера из обучающего множества, коэффициент a управляет степенью сглаживания гауссовых функций (параметр, который подбирается при обучении нейронной сети). Если обучающих примеров достаточное количество, то такой метод даст достаточно хорошее приближение к истинной плотности вероятности. На рисунке 3 приведен в качестве примера вид такой функции в двумерном случае (здесь рассмотрено 6 примеров, находящиеся в 4-х различных точках пространства).

Рис.3. Вид функции плотности вероятности в методе ядерных оценок.

Вероятностная сеть в случае байесовского подхода состоит из входного слоя искусственных нейронов, выходного слоя (количество искусственных нейронов соответствует числу классов) и скрытого слоя (состоящего из “радиальных функций”). Радиальная базисная функция (RBF) разбивает пространство входов в общем случае гиперсферами, каждая из которых задается своим центром и радиусом. В нейронной сети, построенной на радиальных базисных функциях (Bloomhead and Lowe, 1988; Moody and Darkin, 1989; Haykin, 1994), искусственный нейрон нелинейно «реагирует» на расстояние от данной точки до центра, соответствующее этому радиальному элементу. Функция активации радиального элемента представляет собой гауссову функцию с вершиной в центре элемента.

Входной слой осуществляет пре-процессирование данных (обычно входные значения нормируются на размах (ximax - ximin) либо на среднее квадратическое отклонение si соответствующего признака на обучающем множестве). Элемент скрытого слоя подает на вход выходного элемента значение гауссовой функции данного наблюдения. Каждый элемент выходного слоя соединен со всеми радиальными элементами скрытого слоя, относящимися только к его классу, со всеми остальными радиальными элементами он имеет нулевое соединение и имеет линейную функцию активации. Таким образом, выходной элемент просто складывает отклики элементов, принадлежащих его классу. Значения выходных сигналов получаются пропорциональными ядерным оценкам вероятности принадлежности соответствующим классам, и пронормировав их на единицу, можно получить окончательные оценки вероятности принадлежности классам.

Для того чтобы эта вероятность соответствовала реальному распределению вероятностей каждого класса, могут быть предложены два подхода.

В первом случае пропорции классов в обучающем множестве должны соответствовать их вероятностям в генеральной совокупности (априорным вероятностям). Если этого соответствия нет, то впоследствии данный факт должен быть учтен (если стали известны априорные вероятности) путем ввода соответствующих поправочных коэффициентов для каждого класса.

Во втором случае модификация нейронной сети основана на следующей идее. Любая оценка, выдаваемая сетью, получена на зашумленных данных обучающего множества и будет приводить к ошибкам классификации. При этом для каждого класса ошибки первого и второго рода неравнозначны. Для учета этого факта в нейронную сеть может быть добавлен еще один слой, содержащий матрицу потерь. В этом случае вектор оценок получается путем умножения вектора вероятностей, полученного в выходном слое нейронной сети на матрицу потерь, имеющую квадратную форму.

Обучение нейронной сети в данном случае будет сводиться к копированию обучающих примеров в элементы скрытого слоя и подбору сглаживающего коэффициента a. При этом вероятностные нейронные сети не очень чувствительны к выбору a.

Таким же образом может быть построена нейронная сеть для решения задач регрессии. К преимуществам такой нейронной сети следует отнести быстроту ее обучения, к недостаткам – большие размеры получающихся моделей (вероятностная сеть включает в себя все обучающие примеры). Особенностью таких нейронных сетей является неспособность экстраполяции данных, что связано с использованием гауссовых функций активации радиальных элементов скрытого слоя. При удалении от области обучающего множества значение функции очень быстро падает до нуля. В отдельных случаях это может считаться достоинством модели, в других ситуациях – ее недостатком.

2014-02-10

2014-02-10 624

624