Рассмотрим объект, имеющий n случайных состояний S 1, S 2,..., Sn с вероятностями Р (S 1), P (S 2),..., P (Sn). Если одно из состояний объекта обязательно реализуется, а два состояния одновременно невозможны (полная группа несовместных событий), то

.

.

Именно такие объекты в дальнейшем и рассматриваются.

Степень неопределенности состояний объекта зависит от числа n возможных состояний. Например, при бросании монеты их может быть только два, при бросании кубика - шесть. Степень неопределенности состояния объекта возрастает с увеличением n. Однако не только число возможных состояний определяет энтропию объекта. Например, если объект имеет шесть возможных состояний с вероятностями P (S 1) = 0,95, P (S 2) = P (S 3) = P (S 4) = P (S 5) = P (S 6) = 0,01, то с большой достоверностью можно утверждать априори, что он находится в состоянии S 1, неопределенность состояния такого объекта невелика. Если же P (S 1) = 1, а вероятности остальных состояний равны нулю, то объект вовсе не обладает неопределенностью - энтропия такого объекта равна нулю.

|

|

|

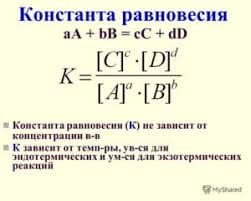

В теории информации энтропия - степень неопределенности состояния объекта, имеющего n возможных состояний с вероятностями Р (S 1), P (S 2),..., P (Sn), определяется выражением

. (4.23)

. (4.23)

Параметр Н (S), введенный Шенноном в 1948 году, называется в теории информации энтропией объекта. Обозначение Н (S) показывает, что энтропия относится к объекту S, его не следует понимать как обозначение функциональной зависимости. Логарифм в формуле (4.23) может быть взят при любом основании, изменение основания приводит только к появлению множителя перед знаком суммы, т.е. к изменению единицы измерения. Наименование этой единицы зависит от выбора основания логарифма при вычислении энтропии: при выборе основания а = 2 единица измерения информации – бит, при а = 10 – дит, при использовании натуральных логарифмов – нит.

Исходя из соображений физической наглядности, будем вычислять энтропию объекта с использованием двоичных логарифмов; тогда

. (4.24)

. (4.24)

Целесообразность использования двоичных логарифмов легко понять, вычисляя энтропию объекта, имеющего два равновероятных состояния. В этом случае P (S 1) = P (S 2) = 0,5. По формуле (4.24) находим:

.

.

Таким образом, за единицу измерения энтропии при выборе двоичных логарифмов принимается степень неопределенности объекта, имеющего два возможных равновероятных состояния. Эта единица измерения называется двоичной единицей или битом.

Если принять при вычислении энтропии десятичные логарифмы, то в качестве единицы информации использовалась бы неопределенность объекта, имеющего десять равновероятных состояний, т.е.

Поскольку в двоичных логарифмах

|

|

|

то отсюда следует, что 1 дит = 3,3 бит, а 1 бит = 0,302 дит.

Рассмотрим основные свойства энтропии.

1. Энтропия объекта есть величина вещественная и неотрицательная, так как  , то

, то  .

.

2. Энтропия объекта равна нулю в том крайнем случае, когда одно из возможных состояний Sn имеет вероятность P (Sn) = 1, т.е.

H (S) = 0 при P (Sn) = 1. (4.25)

Действительно, в формуле (4.24) слагаемое  равно нулю, так как

равно нулю, так как  . Другие слагаемые имеют неопределенные значения типа

. Другие слагаемые имеют неопределенные значения типа  , но можно показать, что

, но можно показать, что  В справедливости этого равенства можно убедиться на следующем примере. Пусть P (Si) = 0,5 m, где m - большое число. Тогда

В справедливости этого равенства можно убедиться на следующем примере. Пусть P (Si) = 0,5 m, где m - большое число. Тогда

.

.

Условие (4.25) следует для рассматриваемого объекта также из физических соображений, так как при P (Sn) = 1 о состоянии объекта известно достоверно заранее, поэтому в объекте нет никакой неопределенности.

3. Энтропия объекта с одинаковыми вероятностями состояний максимальна и равна логарифму числа состояний. Действительно, пусть P (Si) = =1/ n, тогда по формуле для энтропии объекта (4.24) находим

. (4.26)

. (4.26)

Пример 4.2. Пусть имеется объект с двумя возможными состояниями (бинарный объект). Вероятность первого состояния равна Р, тогда вероятность второго состояния из условия  равна 1 - Р. Определим энтропию этого объекта для следующих случаев:

равна 1 - Р. Определим энтропию этого объекта для следующих случаев:

а) состояния объектов равновероятны, т.е. Р 1 = Р 2 = 0,5; Р 1 + Р 2 = 1. Из формулы (4.24) получаем:

б) неравновероятные состояния. Пусть Р 1 = 0,9; Р 2 = 0,1; Р 1+ Р 2 = 1. Тогда

бит;

бит;

|

в) детерминированные состояния. Р 1 = 1; Р 2 = 0; Р 1 + Р 2 = 1:

бит.

бит.

Изменение энтропии бинарного объекта в зависимости от вероятности P (Si) показано на рис. 4.5, из которого видно, что максимум Н (S) = 1 достигается при Р 1 = Р 2 = 0,5, т.е. когда состояния равновероятны. При вероятностях Р = 0 или Р = 1, что соответствует полной невозможности или полной достоверности одного из состояний, энтропия равна нулю.

2015-05-20

2015-05-20 1596

1596