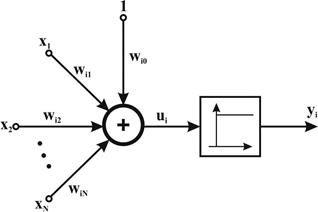

Простой персептрон - это обычная модель МакКаллока-Питса с соответствующей стратегией обучения. Структурная схема и обозначения элементов, i-го персептрона представлены на рис. 4.

Рис. 4. Модель нервной клетки по МакКаллоку-Питсу

Весовые коэффициенты входов сумматора, на которые поступают входные сигналы  , обозначаются

, обозначаются  , а пороговое значение, поступающее с так называемого поляризатора -

, а пороговое значение, поступающее с так называемого поляризатора -  . Нелинейная функция активации персептрона представляет собой дискретную функцию ступенчатого типа, вследствие чего выходной сигнал нейрона может принимать только два значения - 0 или 1 в соответствии с правилом:

. Нелинейная функция активации персептрона представляет собой дискретную функцию ступенчатого типа, вследствие чего выходной сигнал нейрона может принимать только два значения - 0 или 1 в соответствии с правилом:

Где  обозначен выходной сигнал сумматора

обозначен выходной сигнал сумматора

.

.

В приведенной формуле подразумевается, что имеющий длину N вектор х дополнен нулевым членом  , формирующим сигнал поляризации,

, формирующим сигнал поляризации,  . Обучение персептрона требует наличия учителя и состоит в таком подборе весов

. Обучение персептрона требует наличия учителя и состоит в таком подборе весов  , чтобы выходной сигнал был наиболее близок к заданному значению

, чтобы выходной сигнал был наиболее близок к заданному значению  . Это обучение гетероассоциативного типа, при котором каждой обучающей выборке, представляемой вектором х, априори поставлено в соответствие ожидаемое значение

. Это обучение гетероассоциативного типа, при котором каждой обучающей выборке, представляемой вектором х, априори поставлено в соответствие ожидаемое значение  , на выходе i -го нейрона.

, на выходе i -го нейрона.

|

|

|

Наиболее популярный метод обучения персептрона состоит в применении правила персептрона, в соответствии с которым подбор весов осуществляется по следующему алгоритму:

• При первоначально выбранных (как правило, случайным образом) значениях весов  на вход нейрона подается обучающий вектор x и рассчитывается значение выходного сигнала

на вход нейрона подается обучающий вектор x и рассчитывается значение выходного сигнала  . По результатам сравнения фактически полученного значения

. По результатам сравнения фактически полученного значения  ,- с заданным значением

,- с заданным значением  , уточняются значения весов.

, уточняются значения весов.

• Если значение  совпадает с ожидаемым значением

совпадает с ожидаемым значением  , то весовые коэффициенты

, то весовые коэффициенты  не изменяются.

не изменяются.

• Если  = 0, а соответствующее заданное значение

= 0, а соответствующее заданное значение  = 1, то значения весов уточняются в соответствии с формулой

= 1, то значения весов уточняются в соответствии с формулой  , где t обозначает номер предыдущего цикла, а (t + 1) - номер текущего цикла.

, где t обозначает номер предыдущего цикла, а (t + 1) - номер текущего цикла.

• Если  =1, а соответствующее заданное значение

=1, а соответствующее заданное значение  = 0, то значения весов уточняются в соответствии с формулой

= 0, то значения весов уточняются в соответствии с формулой  , где t обозначает номер предыдущего цикла, a (t + 1) - номер текущего цикла.

, где t обозначает номер предыдущего цикла, a (t + 1) - номер текущего цикла.

По завершении уточнения весовых коэффициентов представляются очередной обучающий вектор x и связанное с ним ожидаемое значение  , и значения весов уточняются заново. Этот процесс многократно повторяется на всех обучающих выборках, пока не будут минимизированы различия между всеми значениями и соответствующими им ожидаемыми значениями

, и значения весов уточняются заново. Этот процесс многократно повторяется на всех обучающих выборках, пока не будут минимизированы различия между всеми значениями и соответствующими им ожидаемыми значениями  .

.

| (2.3) (2.4) |

Следует отметить, что правило персептрона представляет собой частный случай предложенного гораздо позже правила Видроу-Хоффа. В соответствии с этим правилом подбор весовых коэффициентов нейрона необязательно персептронного типа проводится по формулам:

|

|

|

,

,

.

.

Аналогичные соотношения используются при подборе веса поляризатора  , для которого входной сигнал всегда равен 1, в связи с чем

, для которого входной сигнал всегда равен 1, в связи с чем

Легко заметить, что если сигналы  и

и  принимают только двоичные значения 0 и 1, то правило Видроу-Хоффа превращается в правило персептрона.

принимают только двоичные значения 0 и 1, то правило Видроу-Хоффа превращается в правило персептрона.

|

Характерная особенность как правила персептрона, так и обобщенного правила Видроу-Хоффа состоит в использовании для обучения информации только о текущем и ожидаемом значениях выходного сигнала. В связи с разрывностью нелинейной функции активации персептрона невозможно учитывать информацию об изменении значения  , (т.е. ее производную). Минимизация различий между фактическими реакциями нейрона

, (т.е. ее производную). Минимизация различий между фактическими реакциями нейрона  и ожидаемыми значениями

и ожидаемыми значениями  может быть представлена как минимизация конкретной функции погрешности (целевой функции) Е, чаще всего определяемой как

может быть представлена как минимизация конкретной функции погрешности (целевой функции) Е, чаще всего определяемой как

,

,

где р означает количество предъявляемых обучающих выборок. Такая минимизация при использовании правила персептрона проводится по методу безградиентной оптимизации. Эффективность метода при большом количестве обучающих выборок относительно невелика, а количество циклов обучения и его длительность возрастают очень быстро, причем без всякой гарантии достижения минимума целевой функции. Устранить эти недостатки можно только в случае применения непрерывной функции активации, при которой целевая функция Е также становится непрерывной, что дает возможность использовать в процессе обучения информацию о величине градиента.

Задание к лабораторной работе:

На основе теоретических основ реализовать алгоритм подбора весовых коэффициентов персептрона программно. Программа должна содержать ввод: динамической матрицы входных сигналов; желаемого значения на выходе 0 или 1; вывод: матрицу весовых коэффициентов, значение выходной функции, количество итераций обучения. Первоначальная матрица весовых коэффициентов должна задаваться случайным образом.

Оформить отчет, который должен содержать блок схему программы.

Контрольные вопросы

1. Из каких элементов состоит персептрон.

2. Что представляет собой функция активации персептрона.

3. По какому алгоритму производиться обучение персептрона.

Лабораторная работа №3

Обучение сигмоидального нейрона.

Цель работы: Изучить принцип обучения сигмоидального нейрона.

2015-05-13

2015-05-13 831

831